為 Kafka Sink Connector 設置接收目標

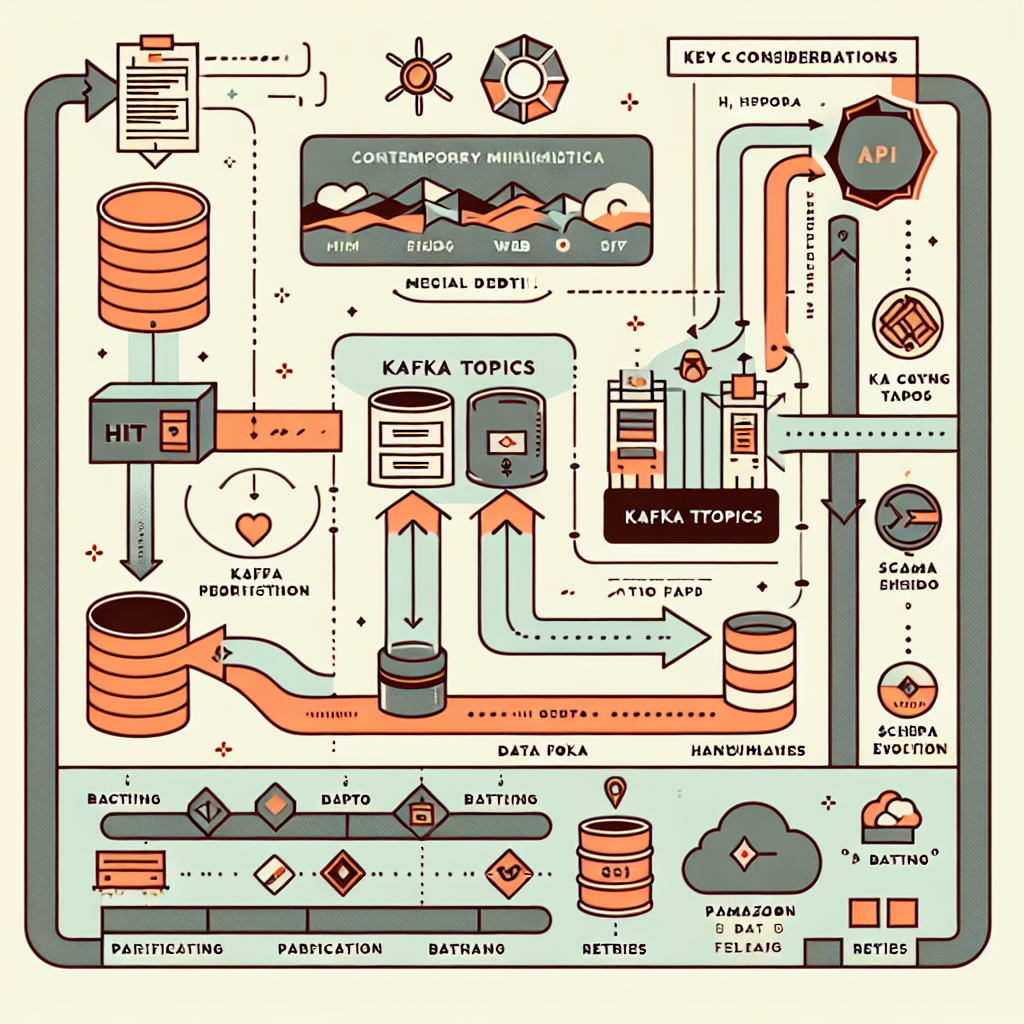

在本指南中,我們將帶您了解如何設置 Kafka 與兩種類型的數據接收端進行集成的過程:

- HTTP 端點:需要一個 HTTP 服務器來接收數據。

- Amazon S3 Bucket:需要具有正確權限的 S3 存儲桶。

這些配置允許 Kafka 主題與外部系統無縫集成,支持實時事件處理和批量存儲以用於分析或存檔。

1. 為 Kafka HTTP Sink Connector 設置 HTTP 端點

HTTP Sink Connector 將 Kafka 主題中的記錄發送到您的系統所公開的 HTTP API。此設置非常適合需要立即處理數據的實時事件驅動架構。

主要功能

- 支持多種 HTTP 方法:目標 API 可以支持

POST、PATCH或PUT請求。 - 批量處理:將多條記錄合併為單個請求以提高效率。

- 身份驗證支持:包括基本身份驗證 (Basic Authentication)、OAuth2 和 SSL 配置。

- 死信隊列 (DLQ):通過將失敗記錄路由到 DLQ,優雅地處理錯誤。

先決條件

- 一個能夠處理 HTTP 請求的 Web 服務器或雲服務(例如 Apache、Nginx、AWS API Gateway)。

- 一個 HTTP Sink Connector 可以發送數據的可訪問端點 URL。

配置步驟

1. 設置 Web 服務器

- 部署您的 Web 服務器(例如 Apache、Nginx)或使用基於雲的服務(例如 AWS API Gateway)。

- 確保 HTTP 端點可通過公共 URL 訪問(例如

https://your-domain.com/events)。

2. 創建端點

- 定義一條路由或端點 URL(例如

/events),用於接收傳入請求。 - 實現邏輯來高效處理和處理傳入的 HTTP 請求。根據應用需求,目標 API 可以支持 POST、PATCH 或 PUT 方法。

3. 處理傳入數據

- 根據應用程序需求解析並處理請求中包含的數據負載。

- 可選地記錄或存儲數據以進行監控或調試。

4. 安全配置

- 使用 HTTPS 加密傳輸中的數據,確保通信安全。

- 實施身份驗證機制(例如 API 密鑰、OAuth 令牌或基本身份驗證)以限制訪問。

2. 為 Kafka Amazon S3 Sink Connector 設置 Amazon S3 存儲桶

Amazon S3 Sink Connector 將 Kafka 主題數據導出到托管在 AWS 上的 Amazon S3 存儲桶中。此設置非常適合需要持久存儲或批量分析的場景。

主要功能

- 精確一次交付:即使在失敗情況下也能確保數據一致性。

- 分區選項:支持默認 Kafka 分區、基於字段的分區和基於時間的分區。

- 可自定義格式:支持 Avro、JSON、Parquet 和原始字節格式。

- 死信隊列 (DLQ):通過將問題記錄路由到 DLQ,處理模式兼容性問題。

先決條件

- 一個 AWS 賬戶,具有創建和管理 S3 存儲桶的權限。

- 擁有適當權限的 IAM 角色或訪問密鑰。

配置步驟

1. 創建 S3 存儲桶

- 登錄 AWS 管理控制台。

- 導航到 S3 服務並創建一個具有唯一名稱的存儲桶(例如

my-kafka-data)。 - 選擇您希望存儲桶託管的 AWS 區域(例如

eu-west-1)。 - 根據需要配置其他設置,例如版本控制、加密或生命周期策略。

2. 設置存儲桶策略

為了允許 Kafka Sink Connector 向您的存儲桶寫入數據,請配置具有適當權限的 IAM 策略:

{

"Version":"2012-10-17",

"Statement":[

{

"Effect":"Allow",

"Action":[

"s3:ListAllMyBuckets"

],

"Resource":"arn:aws:s3:::*"

},

{

"Effect":"Allow",

"Action":[

"s3:ListBucket",

"s3:GetBucketLocation"

],

"Resource":"arn:aws:s3:::"

},

{

"Effect":"Allow",

"Action":[

"s3:PutObject",

"s3:GetObject",

"s3:AbortMultipartUpload",

"s3:PutObjectTagging"

],

"Resource":"arn:aws:s3:::/*"

}

]

}

將 `` 替換為您的實際存儲桶名稱。

該策略確保:

- Connector 可以列出所有存儲桶(s3:ListAllMyBuckets)。

- Connector 可以檢索存儲桶元數據(s3:GetBucketLocation)。

- Connector 可以上傳對象、檢索它們以及管理分段上傳(s3:PutObject、s3:GetObject、s3:AbortMultipartUpload、s3:PutObjectTagging)。

關鍵考慮事項

對於 HTTP 端點:

- 批量處理:如果需要在單個請求中發送多條記錄,請在您的 Connector 設置中配置批量處理。

- 重試機制:確保實施重試邏輯以應對瞬態網絡故障。

對於 Amazon S3 存儲桶:

- 數據格式:根據下游處理需求選擇格式,例如 JSON、Avro 或 Parquet。

- 分區策略:使用基於時間或字段的分區來高效組織 S3 中的數據。

結論

設置 Kafka Sink Connectors 的接收目標可以實現 Kafka 主題與外部系統(如 API 或雲存儲)之間的無縫集成。無論是將實時事件流式傳輸到 HTTP 端點還是將數據存檔到 Amazon S3,都可以通過這些配置提供靈活性和可擴展性,以滿足多樣化的用例需求。

通過遵循本指南,您可以確保跨基礎架構高效地流動數據,同時釋放 Kafka 生態系統的強大能力。

如果有任何進一步問題,歡迎隨時提出!