理解大語言模型中的變壓器架構

在不斷發展的人工智能領域中,語言模型已成為現代技術進步的基石。像GPT-3這樣的大型語言模型(LLMs)不僅捕獲了公眾的想像力,還根本改變了我們與機器交互的方式。在這些模型的核心是一種創新的結構,稱為變壓器架構,它革命性地改變了機器理解和產生人類語言的方式。

變壓器架構的基礎

變壓器模型在Vaswani等人於2017年發表的論文”Attention is All You Need”中提出,從傳統的循環神經網路(RNN)方法轉移過來。與RNN逐步處理數據不同,變壓器使用稱為自注意力的機制同時處理句子中的所有單詞。這讓模型能學習單詞相對於句子中所有其他單詞的上下文,而不僅僅是與其相鄰的單詞。

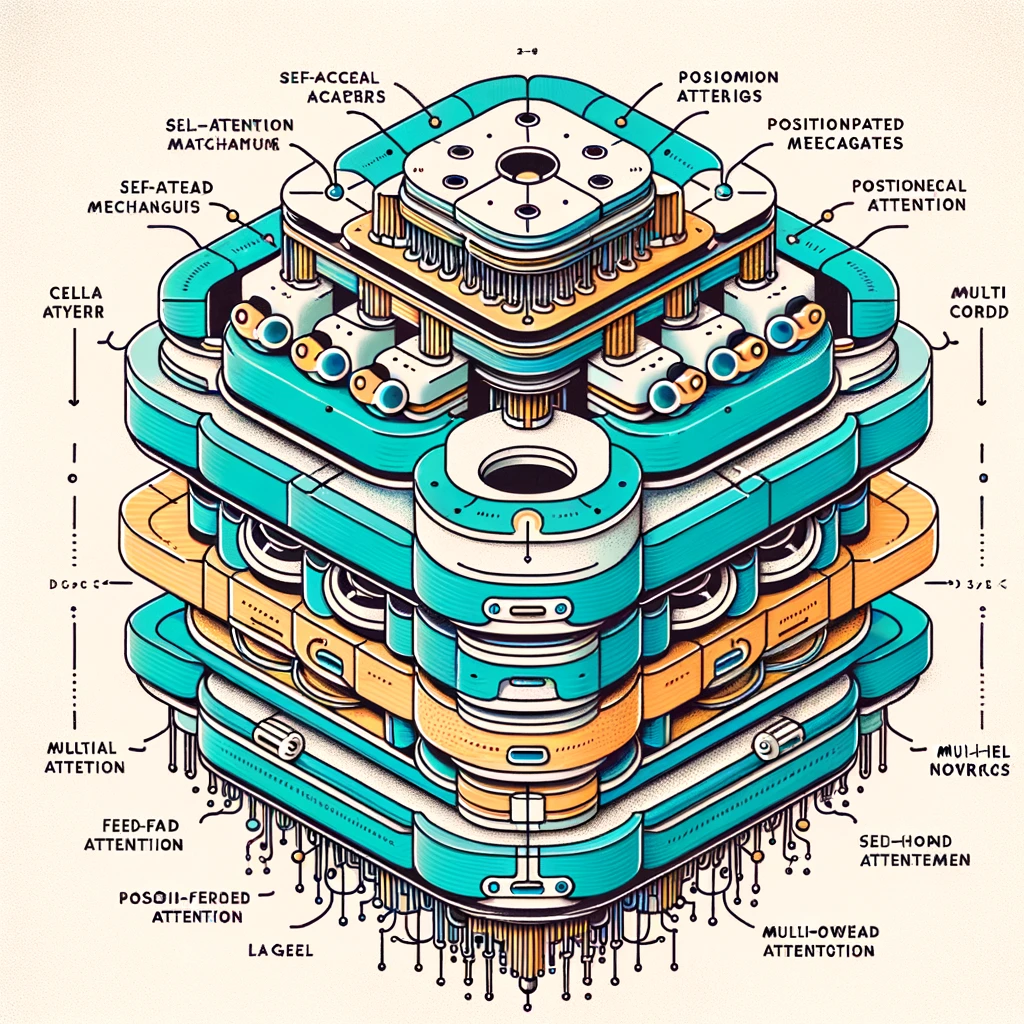

變壓器的關鍵組件

自注意力: 這一關鍵組件幫助變壓器理解語言動態,讓它對句子中每個單詞的重要性進行權衡,不管它們的位置距離如何。例如,在句子”The bank heist was foiled by the police.”中,自注意力讓模型能強烈地將”bank”與”heist”聯繫在一起,即使它們並非相鄰。

位置編碼: 由於變壓器並不是按序處理單詞,所以它們使用位置編碼來包含有關輸入序列中每個單詞位置的信息。這確保了單詞在正確的上下文中被使用。

多頭注意力: 這一變壓器的特性讓它能夠同時關注句子的不同部分,為對上下文的理解提供了更豐富的信息。

前馈神經網絡: 變壓器的每一層都包含一個前馈神經網絡,這種網絡對不同位置進行分別且相同的操作。這一層可有助於優化注意力層的輸出。

訓練變壓器

變壓器通常以兩個階段進行訓練:預訓練和微調。在預訓練階段,模型從大量的文本數據中學習一般語言模式。在微調階段,根據特定任務(如問答或情感分析)對模型進行調整。這種訓練方法,稱為迁移學習,使單個模型可應用於廣泛的任務。

變壓器模型的應用

變壓器模型的多功能性在其應用範圍中顯而易見。從驅動複雜的語言理解任務,如Google的BERT用於更好的搜索引擎結果,到為產生任務(如OpenAI的GPT-3用於內容創建)提供支持,變壓器在NLP技術的最前線。它們在機器翻譯、摘要生成,甚至在富有同情心的聊天機器人的開發中都十分關鍵。

挑戰與未來方向

儘管成功,變壓器也面臨著挑戰。它們對大量計算資源的需求使它們對更廣泛的研究社區的訪問性較低,並引起環境問題。此外,它們可能會延續其訓練數據中的偏見,導致公正和道德問題。

正在進行的研究旨在通過開發更有效的變壓器模型和減輕偏見的方法來解決這些問題。變壓器的未來可能會使它們在AI驅動的世界中變得更加重要,影響著超越語言處理的領域。

結論

變壓器架構無疑改變了人工智能景觀,使語言模型更加複雜和多功能。隨著我們持續改進這項技術,其擴大和增強人機交互的潛力無窮無盡。

透過體驗像Hugging Face這樣的平台來探索變壓器模型的功能,該平台提供了對預訓練模型的訪問,以及訓練自己模型的工具。深入變壓器的世界,探索AI的未來!

進一步閱讀和參考

- Vaswani, A., 等. (2017). Attention is All You Need.

- Devlin, J., 等. (2019). BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding.

- Brown, T., 等. (2020). Language Models are Few-Shot Learners.